Hoe managen we de almaar groeiende hoeveelheid data?

Er zit een directe koppeling tussen de ontwikkelingen in de digitale wereld en de datacenters die wij als datacenter-specialisten ontwerpen, bouwen en beheren. Wie zich in deze sector wil voorbereiden op de toekomst doet er dus verstandig aan goed naar deze trends te kijken. Alleen dan kunnen we immers de innovaties selecteren en implementeren die ons in staat stellen om als datacenters ook in de toekomst onze (interne of externe) klanten optimaal te bedienen. Jos Bijvoet volgt al vele jaren de ontwikkelingen in de ICT- en datacenter-wereld op de voet en zet in dit artikel een aantal belangrijke trends op een rij.

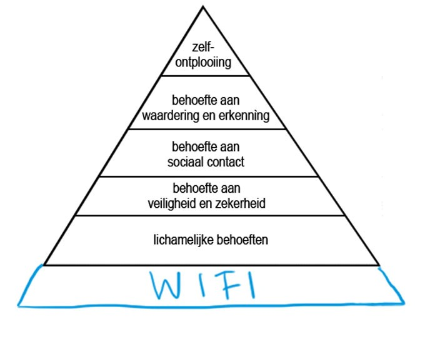

Iedereen kent inmiddels wel dat oncomfortabele gevoel als we geen smartphone tot onze beschikking hebben. Er is zelfs een term voor dat gevoel: ‘nomophobia’. Tussen 2016 en 2020 is het aantal potentiële patiënten in de wereld die aan deze aandoening lijden gegroeid met 40% tot een slordige 3,8 miljard. Statistieken vertellen dat we per dag gemiddeld 2,42 uur kijken naar het scherm en 2617 swipen en klikken. Constante beschikbaarheid van mobiel verkeer (Wifi/4G) is een primaire behoefte geworden. Wie kent niet de met Wifi uitgebreide Pyramide van Maslow’? Voor de zekerheid heb ik een met de hand aangepaste versie in figuur 1 opgenomen.

Figuur 1. Abraham Maslow’s ordening van motivatie behoeften (1943). In dit geval aangevuld met Wifi.

Inmiddels is de vraag of de aanpassing - internet is belangrijker dan primaire behoeften - nog wel de lading dekt? Wat te denken aan toevoeging als: batterij, Twitter, WhatsApp, Facebook, Netflix en dergelijke. De volgorde van importantie laat ik graag aan de lezer. Waar het mij echter om gaat, zijn de gevolgen van dit soort ontwikkelingen.

De hoeveelheid data die we produceren blijft groeien en daarmee dus ook de opslag van die data. Maar weten we nog welke data we waar hebben opgeslagen en hoe we die weer beschikbaar maken? Moeten we deze gegevens (nog) beschikbaar houden? En hebben we een retentiebeleid?

Heel veel data

Een rapportage van International Data Corporation (IDC) van mei 2020 spreekt de verwachting uit dat dit jaar meer dan 59 zettabytes (ZB) aan data zal worden geproduceerd, opgehaald, gekopieerd en geconsumeerd in de wereldwijde ‘datasphere’. Het rapport voorspelt dat de hoeveelheid data die in de komende drie jaar geproduceerd wordt meer zal zijn dan de hoeveelheid data over de afgelopen dertig jaar. En in de komende 5 jaar zal de wereld 3 keer zoveel data produceren dan er is geproduceerd in de afgelopen 5 jaar.

De COVID-19 pandemie lijkt bij te dragen aan deze enorm toenemende hoeveelheid data door de abrupte groei van het aantal mensen dat vanuit huis is gaan werken. Ook In Nederland was een forse toename van dataverkeer goed zichtbaar bij Amsterdam Internet Exchange.

Verwachte groei is verbijsterend

In de jaren 90 was het aantal bedrijven dat meer dan 1 TB aan data had op twee handen te tellen en bestonden uitdagingen uit het maken van een back-up van die 1 (!) terabyte binnen een uur. Dit voelt vreemd aan als we de statistieken van vandaag in overweging nemen. Die gaan er vanuit dat de wereldwijde hoeveelheid data zal groeien naar een verbluffende 175 zettabytes (dat is 175 x 10.000 TB) in 2025.

De voorspelde groei is net zo verbijsterend als ook begrijpelijk. Nog niet zo lang geleden was het gebruikelijk dat belangrijke data als e-commerce, ERP, e-mail en soortgelijke zaken is opgeslagen in de databases van de organisatie. Hoewel nog altijd relevant, is vandaag de dag juist ongestructureerde data van toenemend belang. IoT-data, streaming data, geo-data, gebruikersdata en dergelijke vormen de levensader van veel bedrijven. De verwachting is dat tegen het eind van 2020 een slordige 200 miljard apparaten data zullen genereren. IDC voorspelt dat tegen 2025 zes miljard gebruikers dagelijks van data afhankelijk zijn. Dat is een slordige 75% van de wereldbevolking!

In 2025 zal er, als de voorspelde groei gerealiseerd wordt, elke 18 seconden ten minste één interactie plaatsvinden door ieder verbonden individu. Analisten verwachten dat IoT-apparaten tezamen meer dan 90 zettabytes aan data zullen genereren.

Ik ben er, net als velen van ons, van overtuigd dat het ‘internet van dingen’ ons in toenemende mate zal omringen met handige ‘slimme dingen’. Die ‘dingen' zullen onafgebroken meten, waarnemen, luisteren en kijken wat wij aan het doen zijn. Veel van deze systemen zijn continu aan het leren van wat ze zien en horen of van feedback van andere slimme apparaten.

Het gevolg is dat deze door data gedreven wereld altijd ‘aan’ staat, ons continu volgt, voortdurend informatie opslaat, altijd toezicht houdt, luistert en (be)kijkt. Deze wereld is dan 8760 uur per jaar ‘aan’ en produceert dus continu nieuwe data.

'Leuke applicaties'

Deze enorme berg data opent de deur naar interessante en vaak ook zinnige inzichten die van dienst kunnen zijn bij dagelijkse bezigheden en vooral ook voor bedrijven. Een snelgroeiend aantal bedrijven (h)erkent de waarde van deze data en is er actief naar op zoek. Als je een pagina opent op internet word je onmiddellijk besprongen door het ‘Cookie Monster’. Het weigeren van, tenminste de als noodzakelijk benoemde, cookies levert soms algehele verbanning op van de gezochte pagina of levert beperkingen. Wie er wel eens dieper naar gekeken heeft, weet dat het geheel vermijden een tijdrovende en vrijwel onmogelijke taak is. Bovendien leveren updates van sites en regels op dat het hele spel weer over nieuw begint.

En wat te denken van wat wij zelf uploaden in al die leuke applicaties. Professor Ian Bitterlin heeft al in 2014 gesteld dat er in een maand meer video geüpload werd op YouTube dan een tv-station in een jaar (24x365) kan uitzenden. En dan hebben we het nog maar niet over de sociale media waar we, al dan niet vrijwillig, meebouwen aan de berg met data. Bitterlin staat ook even stil bij een conclusie uit 2012 over energieverbruik. Het 1.7 miljard keer bekijken van de Gangnam Style-video betrof meer dan het jaarlijkse energieverbruik van 9 miljoen inwoners van Burundi (Afrika). Het met al dat up-, en downloaden samenhangende energieverbruik zullen we verder maar laten voor wat het is.

Er is groeiende behoefte aan steeds snellere verwerking van data. De ontwikkeling van supercomputers staat daarom ook niet stil. De Top 500-lijst van juni 2020 laat een nieuwkomer zien die IBM’s Summit ver achter zich laat. Het nieuwe topsysteem, Fukaku, heeft een verbluffende capaciteit van 415,5 petaflops (in HPL-mode). In gereduceerde precisie, zoals gebruikt voor AI-applicaties, is Fugaku’s piek maar liefst 1000 petaflops (1 exaflops). Ook ‘gewone’ servers worden sneller en dat geldt ook voor onze PC, laptop en smartphone. Dus komen we de beperkingen tegen in onze netwerken en verbindingen. Bedrijfsnetwerken worden/zijn aangepast en gelukkig zijn 5G en glasvezel in aantocht.

Impact op datacenters

Al deze door ons geproduceerde en gevraagde data moet ook ergens worden verwerkt en opgeslagen. Door de exponentiële groei is de datacenterwereld een flink groeiende sector.

Het eerdere genoemde bureau IDC definieert drie primaire locaties waar data wordt verwerkt. The Core (traditionele en cloud-datacenters), The Edge en zogenaamde Endpoints (inclusief IoT-apparaten). Tezamen vormen deze drie de wereldwijde ‘datasphere’ waar alle data doorheen loopt.

Dit leidt uiteraard ook tot de vraag hoe we omgaan met de opslag die voortkomt uit de constant groeiende datastroom. Daar heeft IDC ook een antwoord op en dat is de verwachting dat cloud-datacenters de plaats zijn waar bedrijfsdata wordt opgeslagen. Zij voorspellen dat tegen 2025 49% van alle data in de wereld gehuisvest zijn in de public cloud. Cloud-datacenters zullen een belangrijke rol vervullen in de verwerking van de groeiende stroom data. In de huidige markt is al een versmelting van Core en Edge waarneembaar als het gaat om relevante data die snel beschikbaar moet zijn.

De datacenter-markt groeit daarnaast ook door de toenemende vraag naar (netwerk)apparatuur als routers, switches, firewalls, biometrische en andere beveiligingssystemen en niet in de laatste plaats datacentermanagementsoftware en applicaties. Om maar niet te spreken over de kapitaalintensieve fysieke/facilitaire kant van deze groei.

Relevante data

De relevantie van data is mijns inziens lastig te definiëren. Is het die ene foto, die factuur, dat contract, dat plan, de vluchtgegevens van het vliegtuig of de motoren, die e-mail?

- Relevant - ja, op het moment dat je er gebruik van wilt maken

- Relevant - nee, als je er jaren niets mee doet.

Voor elk individu en voor elke onderneming ligt dat dus iedere keer weer anders. Als bedrijf moeten we op grond van wet- en regelgeving sommige zaken een vastgestelde termijn bewaren. Of we willen juist oude archieven digitaliseren om ze op die manier beter te kunnen veiligstellen voor de toekomst. (Snelheid van) beschikbaarheid en frequentie van opvragen zijn zeker aspecten die een rol spelen. Bedrijfsmatig wordt in de praktijk rekening gehouden met deze en vele andere aspecten om opslag efficiënter te maken.

Toch is er ook veel opgeslagen data die we als niet-relevant zouden moeten bestempelen. Juist in de achterliggende periode is het aantal grappen dat via sociale Media zijn verspreid enorm. Nog zorgelijker wordt het als we die grap/foto/video nog even doorzenden naar vele van onze contacten. Bij die contacten wordt de data op de smartphone opgeslagen en daarna - bij de meesten van ons - ook bij Google of Microsoft en bij Samsung of Apple vastgelegd. Uiteraard afhankelijk van het merk en systeem en wat je zelf aan actief beheer van je smartphone onderneemt. Naar verwachting zal dus die ene leuke foto/video wereldwijd ontelbare keren ergens staan opgeslagen. Relevant? Die piek bij AMS-IX sinds maart zal vast niet alleen van thuiswerk zijn - toch?

'Rot' en 'Dark'

De immer groeiende berg aan data is in toenemende mate ook een risico en een kostenpost voor ondernemingen. Big data is voor veel bedrijven een interessante - zeg maar - 'pot met informatie’ die, mits goed gemanaged en geanalyseerd, een schat aan waardevolle data zal leveren. Maar wordt al die data wel zo goed gemanaged?

Een alweer wat ouder rapport van storage-aanbieder Veritas geeft (een) antwoord op deze vraag. Van alle data die de deelnemers aan dit onderzoek in hun bedrijf bezitten is maar 15% van alle data daadwerkelijk bedrijfskritisch te noemen.

Veritas onderkent 3 soorten data:

1. Bedrijfskritische Data (Business Critical Data) - Dit betreft data die is geïdentificeerd als vitaal voor de voortgang van het bedrijf en operationeel succes. Deze data dient proactief te worden gemanaged met maximaal te worden beschermd.

2. Verouderde-, overtollige- en onbeduidende data (Redundant, Obsolete or Trivial of wel ROT data) - Dit betreft data geïdentificeerd als overtollig of duplicaat (soms zelfs triplicaat). Verouderd omdat het geen waarde meer heeft voor de (kritieke) bedrijfsvoering, Onbeduidend omdat het in geheel geen waarde (meer) heeft voor het bedrijf. Dit soort data dient proactief geminimaliseerd te worden door op reguliere basis data veilig te verwijderen.

3. Donkere data (Dark Data) - Dit betreft data waarvan de waarde niet is vastgesteld en kan zowel uit bedrijfskritische data als uit onbeduidende data bestaan. In beide gevallen vergt het echter middelen. Deze data dient zo snel geanalyseerd en geordend te worden als waardevol (of waardeloos) is. Dit is mede van belang omdat de data een hoeveelheid mogelijk ook niet-compliant data kan bevatten die daarmee een groot risico voor het bedrijf kunnen vormen.

Dark data is serieus riskant. Naast een (niet-kwantificeerbaar) risico genereert ‘donkere data’ ook dusdanig hoge kosten dat het zeer de moeite waard is om het licht te laten schijnen over deze data.

Het onderzoek van Veritas maakt zichtbaar dat bedrijven in EMEA gemiddeld 54% dark data, 32% ROT-data en maar 14% identificeerbare bedrijfskritische data bezitten. Onverminderd zo doorgaan levert alleen al dit jaar een slordige 750 miljard dollar aan kosten op voor opslag en management. Zo stelde het rapport al in 2018. Ik heb het dan over de kosten voor EMEA. Wereldwijd is het bedrag vele malen groter.

Wal en Schip

Als men al in 2018 deze zorgelijke (ja, dat meen ik serieus) situatie in het vizier had, dan zou je verwachten dat de wal het schip toch wel inmiddels zal hebben gekeerd. Niets is echter minder waar. Uit de door Veritas gepubliceerde update over 2019 blijkt dat het gemiddelde (wereldwijde) percentage bedrijfskritische data in beheer gedaald (!) is van 15 naar 12%. Dit betekent dat de hoeveelheid ‘donkere data’ en ‘verouderde/overbodige/onbeduidende data’ dus nog steeds groeit. Kosten en (on)bekende risico’s groeien dan uiteraard vrolijk mee!

Als voornaamste oorzaak zien de onderzoekers het ontbreken van een eenduidige strategie op het gebied van datamanagement in (de onderzochte) bedrijven. Het lijkt erop dat er weinig bedrijven zijn die een sluitend proces hebben om data te beoordelen en vervolgens waar nietig en nodig te deleten en managen. Dat vind ik - zeg maar - ‘opvallend’. Juist nu de hoeveelheid data exponentieel toeneemt.

Auteur Jos Bijvoet was meer dan 30 jaar verantwoordelijk voor datacenter/infrastructuur management bij een grote financiële multinational en geniet erkenning voor zijn visie in de internationale datacenter gemeenschap.